Ana Marcet, Marta Vergara-Martínez y Manuel Perea

ERI-Lectura, Universitat de València, España

(cc) Hiltrud Moller-Eberth.

En este trabajo examinamos los procesos de reconocimiento visual de palabras en una población que muestra generalmente un bajo nivel lector: las personas sordas prelocutivas. Si bien investigaciones recientes han mostrado que las personas sordas hacen uso efectivo de la información proveniente de la forma visual de las palabras, no lo hacen de su sonido. Por tanto, en la intervención educativa, sería conveniente que los profesionales que trabajaran con personas sordas emplearan procedimientos que les permitieran desarrollar una correspondencia más estable entre las letras y sus sonidos.

De acuerdo con la Comisión para la Detección Precoz de la Sordera, aproximadamente uno de cada mil niños en España nace con sordera profunda. Gracias a la inclusión que existe actualmente en nuestras escuelas, niños sordos y oyentes comparten aula, y es en el ámbito de la lecto-escritura donde la gran mayoría de los niños sordos encuentra más dificultades. Es bien conocida la alta relación entre el nivel lector y la capacidad de identificar y utilizar los elementos constituyentes del habla (conciencia fonológica; Herrera y Defior, 2005). En el caso de los niños sordos, debido a su falta de audición, su grado de conciencia fonológica es menor que en sus iguales oyentes, lo que repercute en su habilidad lectora. Dadas las ventajas que proporciona un buen nivel lector en la sociedad actual, es crucial desarrollar procedimientos que mejoren tanto el proceso de aprendizaje de la lectura como la comprensión lectora de las personas sordas a lo largo de su vida. Para ello, es imprescindible conocer los procesos cognitivos que difieren entre personas sordas y oyentes durante la lectura, en particular respecto al papel de la forma visual de las letras que forman las palabras (ortografía) y su sonido (fonología).

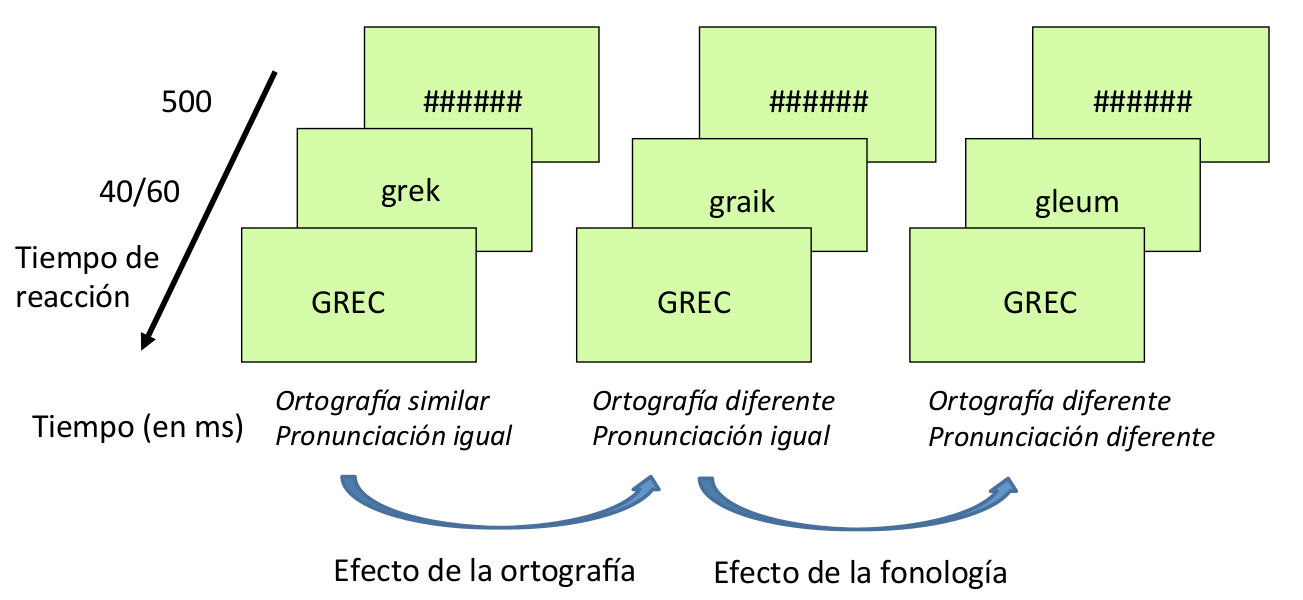

Para examinar conjuntamente los efectos de la ortografía y la fonología durante el reconocimiento visual de palabras, Bélanger, Baum y Mayberry (2012) realizaron un experimento de decisión léxica (esto es, decidir si una cadena de letras forma una palabra real o no) en el que participaron personas sordas prelocutivas y oyentes. A continuación nos centraremos en las cadenas que sí formaban palabras reales, a las que llamaremos “palabras-test”, ya que nos interesa evaluar la calidad de su procesamiento. Cada palabra-test iba precedida brevemente por otra cadena de letras, que llamaremos “señal”. La manipulación clave en el experimento era el tipo de relación que existía entre la señal y la palabra-test. Había tres tipos de relación (véase la Figura 1): 1) una condición en la que la señal y la palabra-test se pronunciaban de la misma manera y se escribían de forma parecida; 2) una condición en la que la señal y la palabra-test se pronunciaban de la misma manera, pero se escribían de forma diferente; y 3) una condición en la que la señal y la palabra-test no se parecían ni en su pronunciación ni en su escritura.

Figura 1.- Condiciones de los estímulos-señal y estímulos-test en el experimento de Bélanger et al. (2012). Obsérvese que la palabra francesa “GREC” se pronuncia /gʀɛk/, al igual que los estímulos-señal “grek” y “graik”. La pronunciación de “gleum” es /gløm/.

Si la persona es capaz de procesar la información ortográfica de la señal, es de esperar que esto le ayude a leer la palabra-test más rápidamente en la condición 1 que en la 2 (efecto de la ortografía). Si, además, la información fonológica de la señal le ayuda a leer la palabra-test, esto conllevará un beneficio de la condición 2 sobre la condición 3 (efecto de la fonología).

Este estudio desveló que tanto las personas sordas como los oyentes se benefician cuando la señal y la palabra-test se escriben de manera similar (condición 1 más rápida que condición 2), pero sólo los oyentes se benefician cuando la señal y la palabra-test comparten únicamente el sonido (condición 2 más rápida que condición 3). Por lo tanto, los oyentes y las personas sordas se apoyan en la forma visual de las palabras al leer, pero solamente los oyentes se benefician de su sonido (véase Bélanger, Mayberry y Rayner, 2013, para evidencia similar durante la lectura de frases).

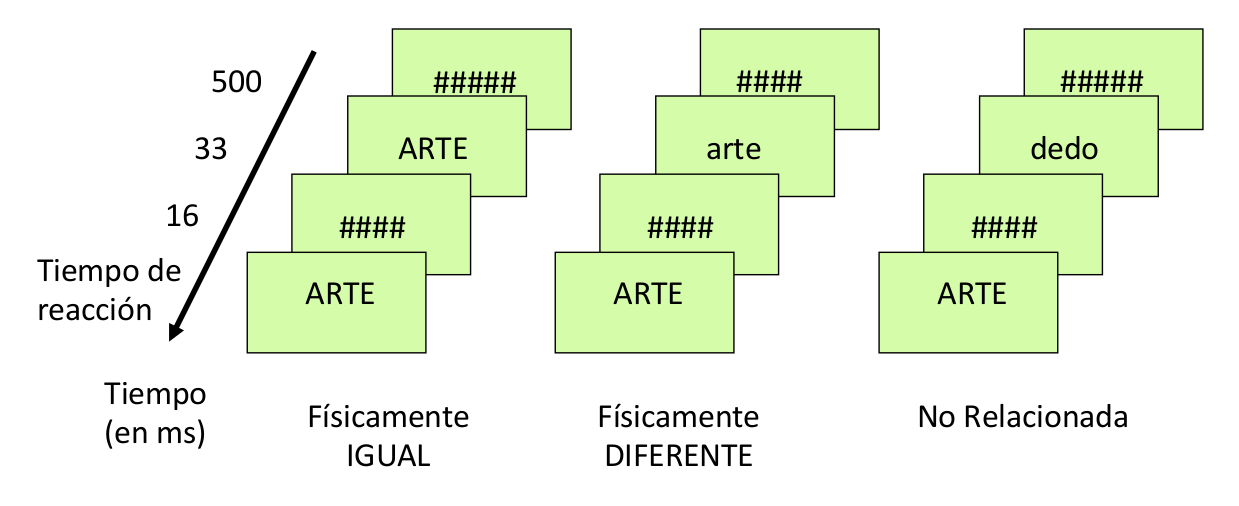

Este déficit en el uso de la información fonológica de las palabras ha sido confirmado recientemente en un estudio de nuestro laboratorio. Se sabe que, en lectores oyentes, el tiempo que se tarda en reconocer una palabra-test como “ARTE” es igual de rápido cuando va precedida brevemente por la señal “ARTE” (una señal físicamente igual) como por la señal “arte” (igual pronunciación, pero forma visual diferente; Jacobs, Ferrand y Grainger, 1995; véase Vergara-Martínez, Gomez, Jiménez y Perea, 2015, para evidencia electrofisiológica). Esto ocurre incluso para palabras que, pronunciándose igual, se escriben en una grafía diferente, lo que sugiere que este efecto tiene una naturaleza fonológica (Pylkkänen y Okano, 2010). Perea, Marcet y Vergara-Martínez (2016) estudiaron este efecto en personas sordas prelocutivas (véase la Figura 2).

Figura 2.- Condiciones de los estímulos-señal y estímulos-test en el experimento de decisión léxica de Perea, Marcet y Vergara-Martínez (2016).

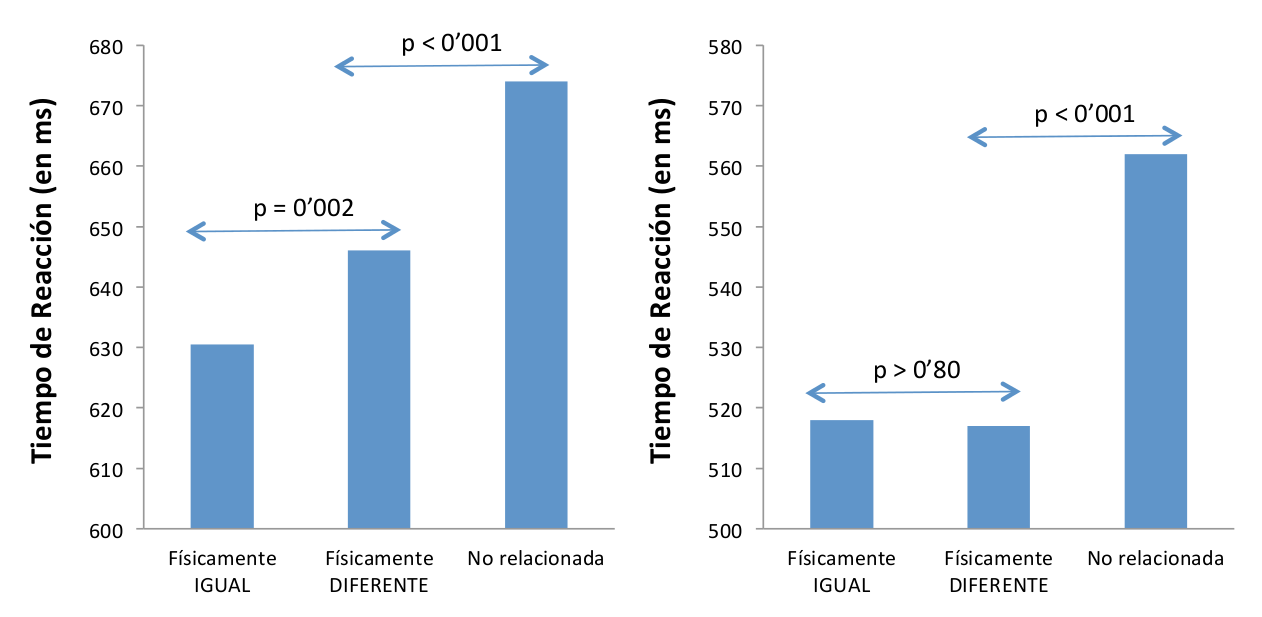

Los resultados mostraron que las personas sordas se benefician menos que los oyentes al leer la palabra-test cuando va precedida de una señal que suena igual, pero visualmente es diferente (arte-ARTE), que cuando la señal es idéntica (ARTE-ARTE; véase la Figura 3). Estos resultados vuelven a mostrar diferencias entre lectores sordos y oyentes que sugieren que las personas sordas no acceden rápidamente a la información fonológica que anula las diferencias físicas entre palabras.

Figura 3.- Tiempos de reacción promedio de cada una de las condiciones en el experimento de Perea et al. (2016) con personas sordas adultas (izquierda) y en el experimento paralelo de Perea, Jiménez y Gomez (2015) con personas oyentes adultas (derecha).

En definitiva, en los últimos años ha habido un creciente interés en el estudio de los procesos de lectura en personas sordas. Estas investigaciones han mostrado que las personas sordas no tienen dificultades en cuanto a la ortografía, pero sí tienen déficits en el procesamiento fonológico. Para poder desarrollar una correspondencia adecuada en la relación entre letras y sonidos durante el aprendizaje de la lectura, una posible estrategia es trabajar con diferentes modalidades de intervención, como el sistema dactilológico, la lectura labial o la propia producción del habla (véase Lederberg, Schick y Spencer, 2013, para una revisión).

Referencias

Bélanger, N. N., Mayberry, R. I., y Rayner, K. (2013). Orthographic and phonological preview benefits: Parafoveal processing in skilled and less-skilled deaf readers. Quarterly Journal of Experimental Psychology, 66, 2237–2252.

Bélanger, N. N., Baum, S. R. y Mayberry, R. I. (2012). Reading difficulties in adult deaf readers of French: Phonological codes, not guilty! Scientific Studies of Reading, 16, 263–285.

Herrera, L. y Defior, S. (2005). Una aproximación al procesamiento fonológico de los niños prelectores: Conciencia fonológica, memoria verbal a corto plazo y denominación. Psykhe, 14, 81-95

Jacobs, A.M., Grainger, J. y Ferrand, L. (1995). The incremental priming technique: A method for determining within-condition priming effects. Perception & Psychophysics, 57, 1101–1110.

Lederberg, A.R., Schick, B. y Spencer, P.E. (2013). Language and literacy development of deaf and hard-of-hearing children: Successes and challenges. Developmental Psychology, 49, 15-30.

Perea, M., Jiménez, M. y Gomez, P. (2015). Do young readers have fast access to abstract lexical representations? Evidence from masked priming. Journal of Experimental Child Psychology, 129, 140-147.

Perea, M., Marcet, A. y Vergara-Martínez, M. (2016). Phonological-lexical feedback during early abstract encoding: The case of deaf readers. PLoS ONE, 11(1), e0146265.

Pylkkänen, L. y Okano, K. (2010). The nature of abstract orthographic codes: Evidence from masked priming and magnetoencephalography. PLoS ONE, 5(5), e10793.

Vergara-Martínez, M., Gomez, P., Jiménez, M. y Perea, M. (2015). Lexical enhancement during prime-target integration: ERP evidence from matched-case identity priming. Cognitive, Affective, and Behavioral Neuroscience, 15, 492–504.

Manuscrito recibido el 12 de febrero de 2016.

Aceptado el 3 de mayo de 2016.