Javier Valenzuela

Dept. de Filología Inglesa, Universidad de Murcia, España

(cc) dlpng.

Cuando conversamos con alguien, no solo procesamos las palabras que emite, sino que prestamos atención a la entonación, gestos manuales, expresiones faciales, dirección de la mirada, postura corporal, etc. Aparentemente, este incremento de señales de distinto tipo (multimodales) debería complicar el proceso comunicativo, ya que tenemos que atender a una cantidad mayor de información y de índole más variada. Sin embargo, todos los estudios apuntan a que la conjunción de señales de distintas modalidades son una ayuda más que un problema a la hora de descubrir el mensaje que se nos quiere comunicar.

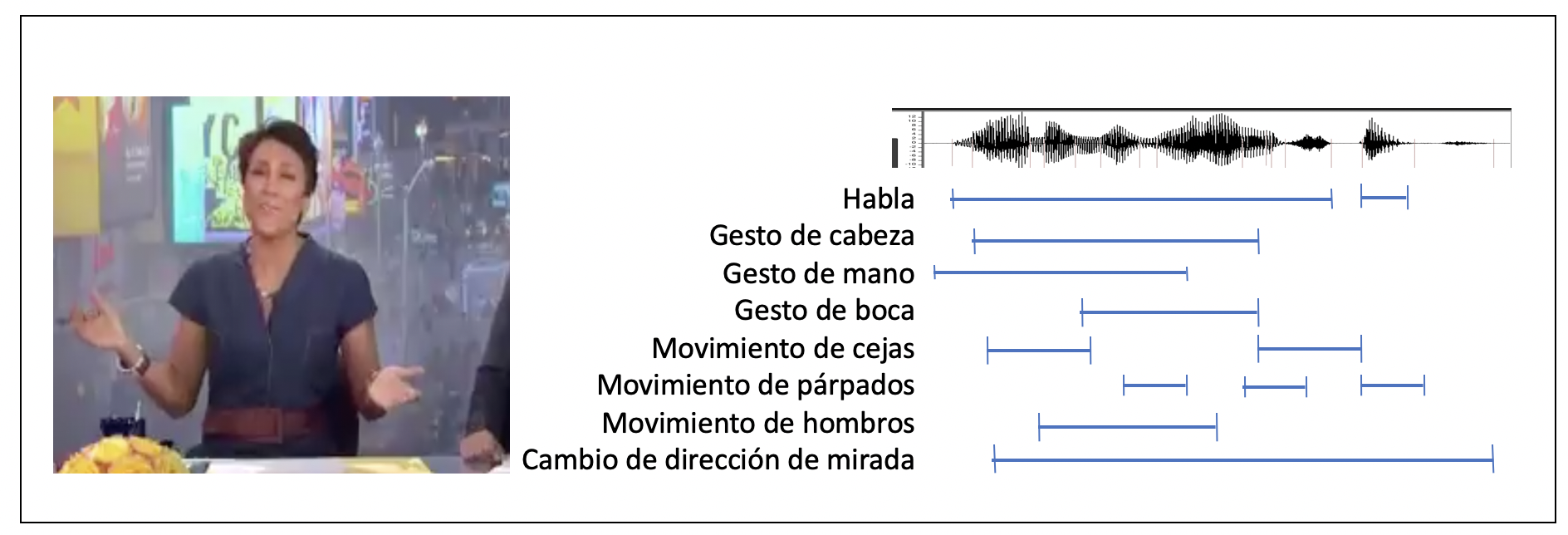

Es poco controvertido asumir que el lenguaje humano evolucionó en un escenario de comunicación en el que al menos dos interlocutores se enfrentan cara a cara y dialogan. En esta situación, ambos interlocutores van alternando sus mensajes, teniendo a su disposición toda una serie de señales, algunas auditivas, otras visuales, para construir un intercambio comunicativo eficiente. En las últimas décadas ha habido una explosión de investigación (véanse, por ejemplo, las recopilaciones de Muller y col., 2013, 2014) que demuestra que los gestos manuales no son un añadido opcional, sino parte integral del sistema de comunicación lingüística. Y la parte no verbal de la comunicación incluye más elementos todavía: determinados movimientos corporales realizados con la cabeza, partes de la cara como las cejas, así como los hombros, los brazos o el torso, la dirección de nuestra mirada o nuestra postura corporal (Figura 1). Potencialmente, todas estas señales pueden ser utilizadas por los hablantes para transmitir su intención comunicativa y por sus interlocutores para descubrirla.

Figura 1.- Ejemplo hipotético de información multimodal en una expresión lingüística.

Esta nueva visión de la comunicación tiene un efecto colateral: en principio, complica enormemente los modelos de procesamiento psicolingüístico. Para empezar, el cerebro tiene que discriminar qué sonidos o movimientos son comunicativos y cuáles no: hay que darse cuenta de que el movimiento del brazo y la mano realizado al señalar algo cuando decimos “¡ahí!” es comunicativo, y descartar otros movimientos accidentales, como coger un vaso, rascarse el brazo o subirse las gafas. A esto se añade una dificultad añadida: estas señales no suelen estar perfectamente alineadas en el tiempo, de manera que un gesto puede hacerse un poco antes o un poco después de lo que se está diciendo. El cerebro, por tanto, debe realizar un esfuerzo adicional no solo para identificar y clasificar correctamente todas estas fuentes dispares de información, sino para agruparlas rápidamente en un todo integrado, un “mensaje” homogéneo recibido por nuestro interlocutor y sobre el que construye su interpretación de la intención comunicativa del hablante. Todo ello parecería indicar que entender un mensaje con toda su complejidad multimodal debería requerir mayor esfuerzo cognitivo que un mensaje unimodal (únicamente verbal).

Sin embargo, la evidencia empírica muestra todo lo contrario. Por ejemplo, Holler y col. (2018) demostraron que las preguntas que incluyen gestos reciben respuestas más rápidas que las unimodales, corroborando investigaciones previas que habían detectado una mayor velocidad de reconocimiento cuando se combina gesto y palabra (Kelly y col., 2010). También se ha sabido durante bastante tiempo que identificamos más rápidamente un sonido vocal cuando podemos ver los movimientos articulatorios del hablante (van Wassenhove, 2005). En este sentido, parece que el lenguaje funciona de la misma manera que otras áreas de la cognición: también reconocemos objetos de manera más rápida cuando se presentan de manera multimodal, por ejemplo, reconocemos más rápido una oveja cuando vemos su imagen junto con el sonido de un balido (Suied y Viaud-Delmon, 2009).

Lo que la evidencia muestra es que la distribución de las señales en distintos puntos desalineados temporalmente ayuda al reconocimiento del mensaje total, posibilitando una de las cuestiones clave de la comprensión comunicativa: la predicción, la capacidad de prever qué es lo que va a decir o hacer nuestro interlocutor. Así, somos capaces de combinar información procedente de dos “direcciones”: por un lado, de “abajo a arriba” aprendemos a asociar unas señales multimodales con otras, de manera que la presencia de una de ellas ayuda a predecir otra y facilita su identificación. Por otro lado, de “arriba a abajo” el significado que se está diciendo y el contexto en que se hace genera expectativas sobre las señales que se van a recibir, facilitando también su reconocimiento. Así, toda esta información se solapa, y los distintos niveles multimodales, verbales y no verbales, se complementan y desambiguan entre sí, facilitando una integración rápida y eficiente. La multimodalidad, en vez de ser un problema, es más bien la solución.

Esto ha provocado un creciente interés en lo que los investigadores en lingüística cognitiva están empezando a llamar “construcciones multimodales”: estructuras que capturan esas asociaciones entre combinaciones de señales multimodales y los significados comunicativos asociados a ellas. Algunos ejemplos de construcciones multimodales serían la asociación entre cejas levantadas y las oraciones interrogativas (Ekman, 1979; Crespo y col., 2013), la expresión facial asociada a expresiones de negación (incluyendo el movimiento lateral de la cabeza), los gestos faciales y corporales que se suelen realizar al expresar el significado de “no lo sé” o “no me importa” (encogimiento de hombros, gesto con la boca bajando las comisuras de los labios junto con cejas levantadas; Bavelas y Chovil, 2018), o el gesto lateral de izquierda a derecha que se realiza al decir expresiones temporales demarcativas como “de principio a fin” (Pagán-Cánovas y Valenzuela, 2017). Todos estos estudios indican que estamos asistiendo a un cambio de paradigma, a partir del cual la comunicación se va a estudiar no solo en un entorno más realista y ecológico sino teniendo en cuenta además toda su complejidad.

Referencias

Bavelas, J., y Chovil, N. (2018). Some pragmatic functions of conversational facial gestures. Gesture, 17, 98–127.

Crespo Sendra, V., Kaland, C., Swerts, M., y Prieto, P. (2013). Perceiving incredulity: The role of intonation and facial gestures. Journal of Pragmatics. 47, 1–13.

Ekman, P. (1979). ‘About brows: emotional and conversational signals’. En von Cranach, M., Foppa, K., Lepenies, W. and Ploog, D. (eds), Human Ethology. Cambridge: Cambridge University Press, pp. 169-248.

Holler, J., Kendrick, K. H., y Levinson, S. C. (2018). Processing language in face-to-face conversation: Questions with gestures get faster responses. Psychonomic Bulletin & Review, 25, 1900-1908.

Kelly, S. D., Özyurek, A., y Maris, E. (2010). Two sides of the same coin: Speech and gesture manually interact to enhance comprehension. Psychological Science, 21, 260–267.

Müller, C., Cienki, A., Fricke, E., Ladewig, S. H., McNeil, D., y Teßendorf, S. (2013). Body – Language – Communication: An International Handbook on Multimodality in Human Interaction, Vol. 1. Berlin: De Gruyter Mouton.

Müller, C., Cienki, A., Fricke, E., Ladewig, S. H., McNeil, D., y Bressem, J. (2014). Body – Language – Communication: An International Handbook on Multimodality in Human Interaction, Vol. 2. Berlin: De Gruyter Mouton.

Pagán Cánovas, C., y Valenzuela, J. (2017). Timelines and multimodal constructions: Facing new challenges. Linguistic Vanguard, 3(1): 20160087.

Suied, C., y Viaud-Delmon, I. (2009) Auditory–visual object recognition time suggests specific processing for animal sounds. PLoS One, 4, e5256.

van Wassenhove, V., Grant, K., y Poeppel, D. (2005). Visual speech speeds up the neural processing of auditory speech. Proceedings of the National Academy of Sciences, 102, 1181–1186.

Manuscrito recibido el 25 de octubre de 2019.

Aceptado el 17 de noviembre de 2019.