Javier Ortiz-Tudela

LISCO Lab, Goethe Universität, Frankfurt Am Main, Alemania

(cc) OpenAI Microscope.

La popularización de las inteligencias artificiales está suponiendo una revolución a nivel tecnológico y social. El uso del aprendizaje automático está cada vez más extendido también en numerosos campos de la ciencia, y la psicología y la neurociencia no son ajenas. Dentro de la variedad de técnicas disponibles, las redes neuronales se están consolidando como una de las claves de los éxitos recientes de la inteligencia artificial. Su aparente similitud estructural con el cerebro y el uso de terminología neurocientífica suponen una invitación directa para aquellos interesados en saber cómo funciona el cerebro. Pero ¿somos realmente capaces de entender su funcionamiento?

Una de las metas del proceso científico es descubrir las reglas fundamentales que rigen los fenómenos del mundo. Encontrar estas reglas y describirlas en términos matemáticos es lo que nos permite predecir el comportamiento de un sistema concreto en el futuro. Un ejemplo paradigmático de este proceso son las leyes del movimiento de Newton. Estas leyes describen cómo se relacionan entre sí una serie de parámetros conocidos (la posición, la masa, la velocidad, etc.) para poder predecir qué trayectoria va a seguir una pelota lanzada al aire, un paracaidista o un satélite. Si después de aplicar estas leyes a una situación determinada, observamos que nuestras predicciones se confirman, podremos decir que tenemos un modelo que nos permite entender cómo funciona el movimiento de objetos en caída libre.

Este tipo de modelos son una parte central de todos los campos de la ciencia y sus aplicaciones son fáciles de ver en el campo de la aerodinámica, la química o la economía. La psicología y la neurociencia cuentan también con sus propios modelos para predecir fenómenos como el aprendizaje (Rescorla y Wagner, 1972) o el comportamiento prosocial (Lockwood y col., 2016). Como en otros campos, el investigador define una serie de parámetros derivados teóricamente, describe las relaciones de esos parámetros con el fenómeno de estudio y genera un conjunto de predicciones que son contrastadas con los datos comportamentales o de actividad cerebral obtenidos en el laboratorio.

La llegada del aprendizaje automático, la inteligencia artificial y, más concretamente, de las redes neuronales profundas, supone un cambio cualitativo en este proceso. En su formulación más simple, una red neuronal es un modelo matemático organizado en capas compuestas por nodos (o neuronas) que es entrenado para resolver una tarea concreta. Cada nodo y cada conexión entre nodos tiene varios parámetros y una red profunda puede tener miles de nodos. Durante este proceso de entrenamiento, la red ajusta por sí misma sus propios parámetros para intentar optimizar su rendimiento en la tarea. La enorme capacidad de computación de la que ya disponen nuestros ordenadores (y que aumenta cada año) hace que este proceso de optimización pueda ocurrir a una gran velocidad e incluya un número arbitrariamente grande de parámetros. Cuando los comparamos, la capacidad de predicción de las redes neuronales sobrepasa en gran medida la de los modelos clásicos.

No obstante, esta mejora en predicción lleva un coste asociado que puede no ser evidente a primera vista: los modelos basados en redes neuronales se vuelven ininteligibles para nuestros cerebros humanos. A diferencia de los modelos clásicos en los que un investigador define y controla cada uno de los parámetros que el modelo utiliza, las redes neuronales ajustan automáticamente estos parámetros. Es este ajuste automático y a gran escala lo que nos hace perder control sobre qué está haciendo el modelo para realizar su predicción. No podemos comprender todas las transformaciones que la red aplica a la información para realizar su tarea; no podemos saber si la red ha descubierto un principio básico del mundo. Estableciendo una analogía con el ejemplo de las leyes del movimiento de Newton, una red neuronal podría recibir como información de entrada la posición, la masa y la velocidad de un objeto y devolvería una predicción certera de su trayectoria a través del tiempo, pero nosotros no podríamos saber cómo ha llegado a esa conclusión.

Surge entonces una pregunta que los científicos tendremos que resolver en los próximos (no muchos) años: ¿son estos modelos útiles para el avance del conocimiento científico sobre el fenómeno a predecir? O, dicho de otra manera, ¿nos permiten estos modelos realmente entender cómo funciona, por ejemplo, el cerebro? ¿O son tan solo una herramienta de ingeniería, con indudables aplicaciones prácticas, pero que no nos provee (ni lo hará) de comprensión alguna del fenómeno?

Esta pregunta, que no es trivial en ningún sentido, está inspirando gran cantidad de debate en la intersección entre ciencia cognitiva, inteligencia artificial y filosofía. En el fondo, el debate gira en torno a la definición del término «comprensión» y en cómo este se relaciona con el término «predicción». Si soy capaz de anticipar cómo un sistema se va a comportar, ¿estoy entendiendo cómo funciona? Para explicar un fenómeno, ¿necesito ser capaz de resumir una gran complejidad en un principio simple que refleje un mecanismo básico de la realidad? La distinción entre explicación y predicción no es nueva para disciplinas como la filosofía o la estadística, donde estos dos términos suponen aproximaciones teóricas y prácticas distintas (Shmueli, 2010). Sin embargo, la distinción gana especial relevancia a la luz de la explosión en el uso de las redes neuronales.

Desde el propio campo de la inteligencia artificial, se pueden encontrar algunas propuestas recientes con gran potencial en lo que se ha venido a llamar la interpretabilidad de las redes neuronales. Una de las aproximaciones que dominan este campo es la de la visualización de componentes o de productos intermedios de redes (Olah, Mordvintsev, & Schubert, 2017). Proyectos como Microscope pretenden combatir la imposibilidad de aprehender la complejidad de una red concreta mediante visualizaciones que permiten abstraer información inteligible. Además del innegable atractivo que supone la estética de las imágenes generadas, algunas de estas visualizaciones nos proporcionan una sensación de entendimiento que va más allá de conocer la matemática que subyace a la computación de cada neurona: tenemos la sensación de que entendemos qué está haciendo esa neurona.

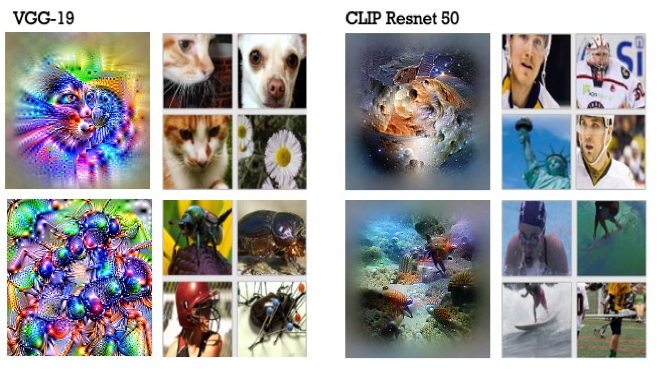

Invitamos al lector a explorar la Figura 1, que muestra ejemplos de visualizaciones para neuronas individuales de dos redes neuronales, VGG-19 y CLIP. Las fotos que acompañan cada una de las visualizaciones son aquellas que generan una mayor respuesta en esa neurona (sus fotos preferidas). Con cuidadosa atención, el lector podrá probablemente identificar rasgos de las fotos de la derecha en las visualizaciones a la izquierda: la neurona en la parte superior izquierda de la imagen parece preferir configuraciones de círculos oscuros similares a caras de animales, mientras que la de abajo parece preferir formas redondeadas y brillantes acompañadas de líneas rectas.

Figura 1.- Visualización de unidades de dos redes neuronales generadas con Microscope. Para cada red, las columnas a la izquierda incluyen visualizaciones generadas artificialmente que representan las características visuales que la unidad está codificando; las columnas de la derecha muestran fotos del mundo real que generan alta activación en cada unidad. Las visualizaciones generadas para la red de la izquierda permiten establecer relaciones con las fotos que activan esa unidad; esto es mucho más difícil para las visualizaciones en los paneles a la derecha. (cc) OpenAI Microscope.

No obstante, aunque esta sea una aproximación prometedora, aún no está claro si esa sensación de entendimiento es equivalente a una comprensión real o incluso si, de serlo así, este tipo de visualizaciones tiene también un límite para nosotros. Sirva como ejemplo de esta limitación las visualizaciones a la derecha de la Figura 1. Mientras que mirar a las fotos preferidas por esta neurona podría sugerir algún tipo de patrón, la visualización de sus parámetros no permite inferir una relación directa con las fotos.

Desde posturas puramente pragmáticas se aboga por el uso de este tipo de redes y, en sus vertientes más extremas, por el abandono de los modelos clásicos dada su limitada capacidad predictiva (Yamins y DiCarlo, 2016). En el otro extremo se sitúan científicos que cuestionan la utilidad teórica que tiene un nuevo sistema artificial y arbitrariamente complejo cuya equivalencia con los fenómenos naturales no está garantizada (Serre, 2019). Posturas intermedias defienden que el uso de este tipo de modelos, si bien puede no ser capaz de proporcionarnos los principios básicos de funcionamiento del cerebro, sí que puede ofrecernos pistas para mejorar el uso de métodos clásicos (Shmueli, 2010). La inteligibilidad de los modelos dependerá en parte de la capacidad de desarrollar una «inteligencia artificial explicable» (Barredo Arrieta y col., 2020). La solución a este apasionante debate, aún lejos de estar resuelto, será de vital importancia en los próximos años ya que, muy probablemente, determinará las herramientas que utilizaremos para responder a nuestras preguntas y moldeará la manera en la que hacemos ciencia.

Referencias

Barredo Arrieta, A., Díaz-Rodríguez, N., Del Ser, J., Bennetot, A., Tabik, S., Barbado,A., García, S., Gil-Lopez, S., Molina, D., Benjamins, R. Chatila, R., y Herrera, F. (2020) Explainable artificial intelligence (XAI): Concepts, taxonomies, opportunities and challenges toward responsible AI. Information Fusion, 58, 82–115.

Lockwood, P. L., Apps, M. A., Valton, V., Viding, E., y Roiser, J. P. (2016). Neurocomputational mechanisms of prosocial learning and links to empathy. Proceedings of the National Academy of Sciences, 113, 9763-9768.

Olah, C., Mordvintsev, A., y Schubert, L. (2017). Feature visualization. Distill, 2(11), e7.

Rescorla, R. A., y Wagner, A. R. (1972). A theory of Pavlovian conditioning: Variations in the effectiveness of reinforcement and nonreinforcement. En A. H. Black y W. F. Prokosy (Eds.), Classical conditioning II: Current research and theory (pp. 64–99). New York: Appleton-Century-Crofts.

Serre, T. (2019). Deep learning: the good, the bad, and the ugly. Annual Review of Vision Science, 5, 399-426.

Shmueli, G. (2010). To explain or to predict? Statistical Science, 25, 289-310.

Yamins, D. L., y DiCarlo, J. J. (2016). Using goal-driven deep learning models to understand sensory cortex. Nature Neuroscience, 19, 356-365.

Manuscrito recibido el 3 de mayo de 2021.

Aceptado el 20 de julio de 2021.