Santiago Sánchez-Migallón Jiménez

Dept. de Filosofía I, Universidad de Granada, España

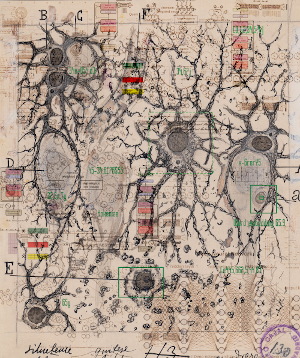

(cc) Santiago Sánchez-Migallón. Basado en imagen de Ramón y Cajal, dp.

Desde la filosofía de la mente, analizamos el nuevo linaje de arquitecturas de redes neuronales profundas para procesamiento de lenguaje natural, centrándonos en el que es, quizá, el modelo más emblemático: GPT-3. Analizamos en qué medida estos algoritmos pueden contribuir al sueño de la inteligencia artificial: la consecución de una inteligencia artificial general.

Mucho se ha escrito desde la salida a escena de los nuevos modelos de procesamiento de lenguaje natural, desde GPT-2 (Radford y col., 2019) hasta el actual Gopher (Rae y col., 2021). Se trata de arquitecturas de redes neuronales profundas diseñadas para generar texto a partir de otro texto dado por el usuario. GPT-3 (Brown y col., 2020) mostró un buen desempeño en las pruebas de evaluación típicas para estos programas: completar la última palabra de un texto, traducción de idiomas, física de sentido común, operaciones aritméticas y comprensión lectora, en las que, a pesar de rendir por debajo de programas específicamente diseñados para cada prueba concreta, llegó a superar el estado del arte en algunas de ellas. GPT-3 no ha pasado por un entrenamiento específico, sino que se busca su uso general, por lo que sería la mejor apuesta actual por la añorada consecución de una inteligencia artificial general.

¿Es un buen modelo para entender la mente humana? La primera respuesta es un rotundo no: su forma de funcionar parece carecer de cualquier tipo de semántica, no parece comprender absolutamente nada de lo que dice, solo imita estadísticamente otros textos dados. Además, su sistema de aprendizaje funciona a partir de millones de ejemplos, algo que parece distar mucho de los necesarios para que un niño adquiera la competencia lingüística que suele mostrar a partir de los tres años. Sin embargo, también existen argumentos a favor. En primer lugar, el conteo del número de ejemplos necesarios para el aprendizaje en humanos es confuso: ¿contamos como un ejemplo cada vez que un niño escucha una palabra o una frase, o quizá debería computarse como varios? Si la percepción humana tiene una frecuencia de 10 a 12 “fotogramas” por segundo, quizá deberíamos contar cada segundo de aprendizaje como 10 o 12 ejemplos. O si pensamos que un recuerdo puede repetirse cientos de veces a lo largo de meses y años, un bebé escuchando hablar a su madre unos pocos minutos podría equivaler a decenas de miles de exposiciones entrenables. Desde otro punto de vista, el progreso de las redes neuronales profundas va hacia la reducción del número ejemplos que necesitan para funcionar. De hecho GPT-3, una vez ha sido entrenado, necesita muy pocos para aprender a realizar nuevas tareas. Así, es de prever un acercamiento progresivo a números de ejemplos más cercanos a los que necesitamos los humanos.

¿Es GPT-3 verdaderamente inteligente? Parecería demasiado tajante negar inteligencia a algoritmos capaces de hacer cosas que, al verlas en humanos, no tenemos duda en designar como inteligentes. Lyre (2020) hace una distinción entre los antiguos sistemas simbólicos y las actuales redes neuronales profundas, subrayando la idea de que hay un salto claro en las segundas: son capaces de aprender mediante estrategias autodidactas y autoentrenadas (que Lyre ve como una especie de intuición), capaces de cierta creatividad. El problema de la caja negra (Castelvecchi, 2016) puede reforzar la idea: ¿por qué negarles a priori la inteligencia si todavía no sabemos bien cómo funcionan? Chalmers (2020), en la misma línea argumentativa, no duda de la posibilidad de que GPT-3 sea un ser dotado con consciencia fenoménica. Si somos capaces de otorgar algún tipo de consciencia primitiva a la caenorhabditis elegans (un nemátodo con 302 neuronas), ¿por qué no suponérsela a un programa con 175.000 millones de parámetros?

Sin embargo, cuando analizamos su funcionamiento interno, el optimismo inicial se desvanece. Estos sistemas han mejorado mucho su desempeño al utilizar las nuevas redes de tipo “transformer” (Vaswani y col., 2017). Grosso modo, funcionan calculando frecuencias de aparición de expresiones en una determinada secuencia de texto. Las transformer analizan las secuencias de entrada de forma simultánea (todos los elementos a la vez y no palabra por palabra como hacían sus precursoras, las redes convolucionales) y, mediante el llamado mecanismo de atención, codifican las relaciones entre sus distintos elementos a varios niveles. GPT-3 no tiene conocimiento explícito alguno de semántica o gramática, ni mucho menos algún tipo de comprensión de lo que escribe. Es quizá un ejemplo muy paradigmático de la habitación china de Searle (Searle, 1980): un mecanismo capaz de mostrar una conducta lingüística competente tal que podría llegar incluso a pasar por humano en el famoso test de Turing (Turing, 1950), pero sin comprensión ni consciencia alguna de lo que hace (para una visión general de las diferentes perspectivas en el tema, véase Bringsjord y Govindarajulu, 2020).

¿Hemos de negarle por ello toda inteligencia? No, o al menos no en un sentido débil del término. No podemos decir en términos absolutos que GPT-3 carezca de semántica. Si bien es cierto que no existe un sujeto que comprenda lo que hace, sus resultados son eficaces para resolver problemas que requieren comprensión de significados. En cierto sentido, no es que GPT-3 carezca de semántica. Todo lo contrario, tiene muchísima, toda aquella de los autores que escribieron los millones de textos con los que está entrenado: tiene una semántica prestada. Cuando de todo su entrenamiento emerge un uso de reglas semánticas para la compleción de textos, GPT-3 está llevando a cabo una conducta inteligente en cuanto a la composición de series de palabras. Y aquí entramos en el tema verdaderamente importante. ¿Qué tipo de comportamiento inteligente puede emerger de sistemas de fuerza bruta como GPT-3? ¿Qué tipo de patrones encuentran en el lenguaje que les sirven para ese buen desempeño lingüístico? ¿Se asemejan a los que utilizamos los humanos? Comprender bien esto podría arrojar mucha luz a la comprensión sobre cómo los humanos generamos o aprendemos a usar el lenguaje.

Referencias

Bringsjord, S., y Govindarajulu, N. S. (2020). Artificial Intelligence. En E. N. Zalta (Ed.), The Stanford Encyclopedia of Philosophy. https://plato.stanford.edu/archives/sum2020/entries/artificial-intelligence/

Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., y Askell, A. (2020). Language models are few-shot learners. arXiv preprint, arXiv:2005.14165.

Castelvecchi, D. (2016). Can we open the black box of AI? Nature News, 538, 20.

Chalmers, D. (2020). GPT-3 and General Intelligence. Daily Nous. https://dailynous.com/2020/07/30/philosophers-gpt-3/#chalmers

Lyre, H. (2020). The State Space of Artificial Intelligence. Minds & Machines, 30, 325–347.

Radford, A., Wu, J., Child, R., Luan, D., Amodei, D., y Sutskever, I. (2019). Language models are unsupervised multitask learners. OpenAI Blog, 1(8), 9.

Rae, J. W., Borgeaud, S., Cai, T., Millican, K., Hoffmann, J., Song, F., Aslanides, J., Henderson, S., Ring, R., y Young, S. (2021). Scaling Language Models: Methods, Analysis y Insights from Training Gopher. arXiv preprint arXiv:2112.11446.

Searle, J. R. (1980). Minds, brains, and programs. Behavioral and Brain Sciences, 3, 417-424.

Turing, A. (1950). Computing machinery and intelligence-AM Turing. Mind, 59, 433.

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., y Polosukhin, I. (2017). Attention is all you need. Advances In Neural Information Processing Systems, 5998-6008.

Manuscrito recibido el 8 de febrero de 2022.

Aceptado el 22 de febrero de 2022.